Важно: в этом обзоре мы не будем рассматривать количество и частоту ядер, поскольку это базовые параметры, напрямую влияющие на общую производительность. О принципе «чем больше ядер, тем лучше» и «чем выше частота, тем больше выполняется операций, но и износ и тепловыделение больше» — написано много, и повторяться нет смысла. Здесь мы хотим поговорить о том, что в меньшей степени на слуху.

Поколение чипа

Удивлены такому началу? А мы нисколько. Чтобы доказать важность этого момента, достаточно задаться вопросом, отчего, к примеру, условный Xeon Platinum 8176 первого поколения Skylake со своими 28 ядрами в пух и прах проигрывает Xeon Gold 6348 третьего поколения Ice Lake c аналогичными количественными параметрами? Речь, само собой, о сырой производительности в бенчмарках типа Passmark.

Ответ прост: они совершенно разные по архитектуре:

- Внутреннее строение компонентов.

- Транзисторные возможности.

- Техпроцесс.

- Энергопотребление и т.д.

Прямую аналогию можно привести из автомобильного мира: двигатель V8 образца 90-х и современный мотор покажут совершенно разные результаты. Естественно, последняя разработка покажет лучшую скорость при меньшем расходе топлива за счет электроники и банального технического прогресса.

Если вы следите за презентациями Intel Xeon Scalable и AMD EPYC, наверняка заметили следующую закономерность между поколениями (для наглядности суммарный процент производительности для 1 итерации составит 100%):

| Поколение | 1 Gen | 2 Gen | 3 Gen |

| Intel | 100% | + 15-30% | + 20-40% |

| AMD | 100% | +20-25% | +20-30% |

Информация бралась на основании тестов в таких задачах, как:

- Скорость компиляции программного кода.

- Научные расчеты в NAMD, GROMACS, LAMMPS.

- Кодирование изображений и видео в WebP2, Intel SVT.

- Рендеринг в Blender, Intel Embree, C-Ray.

Иными словами, условный Intel Xeon Silver 4110 (8/16) не имеет ни малейшего шанса перед Silver 4210(10/20), и уж тем более, 4310 (12/24). И дело не только в увеличении числа ядер и потоков.

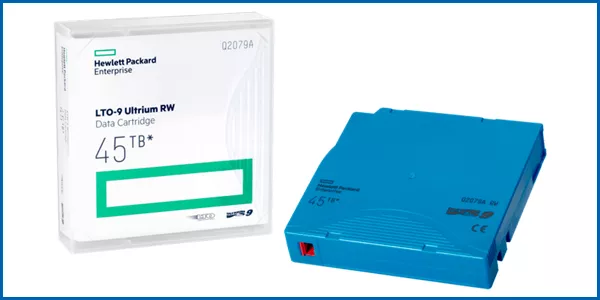

Поддержка оперативной памяти

Здесь речь пойдет не о стандартах DIMM (DDR3/DDR4), и даже не о поддержке ECC-регистров, а о возможности процессора «переварить» определенное количество ОЗУ.

В серверных системах нередко монтируют по 2, 4 и даже 8 сокетов, что позволяет набрать до 4, а то и 6 ТБ памяти на один сокет. Далеко не все процессоры способны потянуть такое количество вычислений.

Для примера возьмем актуальный топ от Intel — Xeon Scalable Platinum 8380. В технических параметрах значится, что он способен обрабатывать до 6 ТБ ОЗУ DDR4-3200 МГц в 8-канальном режиме. Если учесть, что степень масштабируемости 8380 — 2S (до 2 сокетов), суммарно вы сможете использовать 12 ТБ ОЗУ.

Тут стоит отметить, что все чипы Scalable 3 Gen способны обработать 6 ТБ, разница лишь в максимальной частоте ОЗУ.

Однако второе поколение в большинстве своем не видит более 1.5 ТБ на сокет.

Что касается AMD EPYC, у них возможности в плане оперативной памяти скромнее — до 4 ТБ для третьего поколения.

Иными словами, при сборке сервера, который подразумевает 4 и более ТБ ОЗУ под нужды виртуализации, ИИ, машинного обучения и прогнозирования, обязательно учитывайте этот момент.

Архитектурные особенности

В эту категорию хотелось бы выделить ряд параметров, которые либо напрямую, либо косвенно влияют на суммарную производительность серверного оборудования.

КЭШ-память

Этот параметр напрямую говорит о том, как часто процессор будет обращаться к ОЗУ для проведения расчетов. КЭШ делится на 3 категории:

- L1 — самый быстрый и самый малый по объему блок, привязанный к одному ядру.

- L2 — скорость ниже, но объем буфера больше, также привязан к ядру.

- L3 — самый медленный из представленных, однако его объем может достигать более 100 МБ, к тому же кэш доступен для всех ядер.

Хотите знать об этом параметре подробнее? Рекомендуем ознакомиться с соответствующим материалом. В целом, чем больше объем кэш-памяти, тем реже процессор обращается к «медленной» ОЗУ за новой порцией данных, реже простаивает, и быстрее выполняет вычисления.

Поддержка PCI-линий

На сегодняшний день это один из самых скоростных интерфейсов передачи данных между компонентами сервера. Для современного железа актуальными являются стандарты PCI-E 3.0/4.0. Ориентироваться стоит на последние, т.к. их пропускная способность вдвое выше.

На базе PCI-E работают:- NVMe SSD.

- Графические ускорители (RTX, Quadro, Tesla, FirePro).

- RAID-контроллеры.

- USB-адаптеры.

- eSATA-адаптеры.

Чем больше линий поддерживает процессор, тем больше периферии вы сможете подключить к материнской плате сервера без необходимости искать компромиссы.

Например, вам необходимо установить 2 GPU nVidia A100, а также собрать RAID 5 на базе NVMe емкостью по 4 ТБ каждый. Только под эти компоненты необходимо выделить 44 линии, не говоря о периферии.

Добавьте к этому запас в 30-40%, и получите порядке 60 линий PCI-E.

Текущие процессоры Intel способны предложить не более 64 линий на сокет, поэтому для этих целей мы рекомендуем AMD EPYC, поскольку третье поколение этих чипов предлагает по 128 линий PCI-E соответственно.

Масштабируемость

Критический параметр, если сервер создается на базе нескольких процессоров, работающих в связке. Классический пример — HPE Superdome Flex 280, предоставляющий до 8 сокетов суммарно при определенных настройках.

Создавая подобные системы, важно учитывать и возможности масштабируемости самих процессоров. У Intel Xeon Scalable с этим все просто:

- Platinum — до 8 сокетов (8S). Пример — Platinum 8360HL.

- Gold — до 4 сокетов (4S). Пример — Gold 6330H/6348H.

- Silver — до 2 сокетов (2S). Пример — Silver 4216.

- Bronze — до 2 сокетов (2S).

AMD на сегодняшний день не предлагает конфигураций на 4-8 сокетов. Для третьего поколения суммарное количество процессоров ограничено 2 единицами в большинстве случаев (например, EPYC 7763). Исключение — чипы с индексом «P», для которых доступна лишь односокетная компоновка (например, EPYC 7443P/7543P).

Виртуализация

Наверняка вы слышали про облачные серверы, гипервизоры, и удаленное объединение машин для увеличения производительности.

Зачем это надо? Например, вы хотите разместить на одной вполне реальной «железяке» 10 виртуальных машин, где у каждой будет собственная операционная система, набор команд, памяти и разъемов. Этого можно добиться исключительно с помощью софта, используя следующее ПО:

- OpenVZ.

- LXC.

- Hyper-V.

- VirtualBox.

- Bochs.

Однако в этом случае столкнетесь с рядом проблем и ограничений вроде потери ресурсов, снижения вычислительных способностей и проседания по скорости чтения/записи данных.

Использование процессоров с аппаратной поддержкой виртуализации значительно повышает общую производительность «облаков». Поэтому, если вы изначально строите дата-центр с нуля и нацелены на лучшие результаты — настоятельно рекомендуем обращать внимание на эти параметры в ЦП.

Для Intel:- VT-x.

- VT-d.

- VT-EPT.

- TSX-NI.

- AMD-V.

- TLB.

- RVI.

- SEV, SEV-ES, SEV-SNP.

Обращаем внимание, что каждая из представленных технологий рассчитана под определенную ОС, поскольку подобные решения разрабатываются напрямую с вендорами и создателями ПО.

Машинное обучение и искусственный интеллект

Не стоит полагать, что современное железо работает исключительно на заложенных проектных мощностях. Текущее поколение процессоров способно самообучаться, чтобы со временем выполнять определенные задачи быстрее, эффективнее, с меньшим количеством ошибок.

Дайте этому куску кремния пару-тройку месяцев освоиться, и он покажет себя гораздо лучше, чем на момент запуска сервера.

Intel на презентациях не перестают хвалить собственную технологию Deep Learning Boost (DL-Boost), которая выполняет следующие задачи:

- Ускоряет сбор и анализ данных в реальном времени (сбор статистики, работа с Big Data).

- Позволяет лучше работать с нейронными сетями, глубоко настраивая каждый параметр среди тысяч переменных.

- Снижает задержки ввода/вывода для формирования логических выводов.

Технология лучше все показывает себя, если сервер работает с данными типа bfloat16, VNNI и INT8.

И это не простой маркетинг, а реальное преимущество над старыми системами.

AMD идут иным путем и подобными технологиями внутри чипа не располагают. Вместо этого они предлагают отдельное решение Instinct. Но оно конкурирует скорее с GPU nVidia A100 и нацелено исключительно на нужды ИИ и точных вычислений.

Подведем итог

В рамках этого материала мы не раскрыли такие характеристики производительности как:

- Поддержка интеллектуального разгона.

- Расширенные наборы вычислительных команд (SSE, AVX).

- Технологии горячей замены NVMe.

- Рамки теплопакета.

Давайте будем честными — актуальные линейки Intel Xeon и AMD EPYC предлагают этот функционал по умолчанию, причем независимо от конкретной модели процессора. А потому эту информацию можно вынести за скобки, как и количество ядер/потоков.

Помните, что главный параметр производительности — конкретная задача, возложенная на сервер.Если у вас все еще остались вопросы, вы всегда можете их задать специалистам компании Маркет.Марвел. Достаточно изложить ваши требования, и наши профессионалы подберут оптимальное оборудование по соотношению цена/производительность. А также подскажут, какие компоненты можно модернизировать или заменить, чтобы продлить ресурс актуальным мощностям.